自动驾驶纯视觉方案到底有哪些弊端?

- 熵投财富

- 2025-07-05

- 36536

[首发于智驾最前沿微信公众号]随着人工智能与传感器技术的快速发展,自动驾驶汽车逐步走入公众视野。其中,关于感知系统的技术路线选择,始终是大家争论的焦点。尤其是“纯视觉方案”,也就是主要依赖摄像头进行环境感知,不使用或极少使用激光雷达和毫米波雷达的方案,更是在以特斯拉为代表的企业推动下,成为众多车企研究的重点,甚至在24年成为各车企追捧的主要技术方向。纯视觉路线听起来似乎更具性价比,也更接近人类驾驶员的感知方式,但随着技术不断推进,其弊端也逐渐显现。

人类视觉≠机器视觉:认知能力的本质区别

首先需要明确的是,纯视觉方案的提出是希望自动驾驶汽车像人一样“看懂”世界。人类驾驶者主要依靠眼睛和大脑来识别路况、判断距离、预测风险,视觉系统可以覆盖绝大多数驾驶任务。但这并不意味着摄像头加神经网络的组合,就能等同于人类感知。

人类大脑拥有数百万年进化而来的图像处理能力,不仅能精准识别物体,还能根据经验、常识进行推理,如看到小孩在路边玩耍,就知道可能要减速。但深度神经网络的“智能”是在有限样本中训练出来的,在面对陌生或复杂情况时,表现常常不稳定。而且,纯视觉系统没有“触觉”或“深度感知”能力,无法像人类那样通过立体视觉和肌肉反馈协同来判断距离或速度。

因此,即使摄像头分辨率再高,图像处理能力再强,其在实际道路上仍面临对突发情况判断力不足的问题。这种“认知差距”是当前视觉方案最大的问题根源。

深度感知能力有限:距离判断误差大

摄像头擅长的是二维图像捕捉,而自动驾驶所需的是三维空间理解。为了模拟立体视觉,纯视觉方案通常采用双目或多目摄像头,通过视差计算出物体距离。然而,这种方法存在物理极限,受视差基线距离、成像质量和环境光线影响非常大。

在近距离(例如5米以内),摄像头可以较准确地估算距离;但距离一旦拉长到30米甚至更远,基于图像的深度计算误差就会急剧上升。尤其在夜间、逆光、雨雪等恶劣天气条件下,图像质量下降,深度估算更是容易失准。当深夜在高速行驶时,如果误判前方车辆的距离,就可能无法及时制动,导致追尾事故。

相比之下,激光雷达或毫米波雷达采用的是主动测距机制,能直接获得目标距离和速度信息,受光照影响小,误差更小。因此,缺乏高精度的深度感知,是纯视觉方案天然的技术短板。

对光线变化高度敏感:极端环境适应差

纯视觉系统非常依赖自然光照条件,其对光线变化的容忍度远低于雷达类传感器。在白天晴朗的环境中,摄像头可以清晰捕捉路况细节,但在夜间、隧道、强逆光、雪天或雨天等场景下,其性能会迅速下降。

在夜间行车时,若对面车辆开启远光灯,会造成强烈炫光干扰,使摄像头捕获图像严重过曝,目标边缘模糊,甚至无法识别物体;而在大雾天或大雨天,摄像头成像质量也会急剧下降,视觉模糊,信号噪声变大,导致系统错误判断甚至感知失败。

反观毫米波雷达和激光雷达,由于其不依赖可见光,而是通过电磁波或激光主动扫描环境,因此具备较强的全天候工作能力,尤其在低能见度场景下优势明显。纯视觉方案在这些环境下的脆弱性,不可避免地成为其实际部署时的严重障碍。

遮挡与盲区问题难以解决

自动驾驶系统必须能够应对包括视线受阻、车辆遮挡、交叉路口等各类复杂道路场景。在这些场景中,摄像头由于依赖可见光成像,视野受限非常明显,极容易出现“看不见”的盲区。

举个例子,前车在正常行驶,其后方存在行人突然横穿马路的风险。由于纯视觉系统主要依靠摄像头获取前方图像,在完全被前车遮挡的情况下,它无法“看到”正在穿越马路的人,直到前车刹车或变道才可能识别。此时系统的反应时间已非常有限。

训练数据依赖性强,泛化能力弱

视觉感知系统背后的深度学习模型,需要依赖大量标注清晰、覆盖广泛的训练数据。这些数据通常包括各种交通场景、天气条件、道路类型等,用于训练系统识别各种物体和行为。但真实道路的变化极其复杂,总有新情况是模型“没见过”的。

想象一下,若某地区突发暴雨,道路被积水淹没,交通标线消失;或是出现一个没被系统学过的异型交通标志。如果训练数据中没有类似案例,纯视觉模型往往就“看不懂”,甚至会作出错误决策。

更严重的是,深度学习模型往往具有“黑箱”属性,难以解释其为何做出某个判断,给故障排查和系统优化带来巨大难度。而多传感器融合系统(例如激光+视觉+雷达),由于具备多源数据校验机制,可以在一个传感器失效时由另一个补充,从而提供更强的鲁棒性和泛化能力。

缺乏速度感知能力,难以应对高速场景

自动驾驶系统不仅需要识别物体“是什么”和“在哪里”,还要判断“它会往哪里走”、“它走得有多快”。在高速行驶场景下,这种时间敏感性尤为重要。、如在高速路上,系统就需要根据前方车辆的速度和加速度预测其变道行为,做出及时响应。

摄像头虽然能连续捕捉图像帧,但其本身无法直接获取物体的相对速度信息。纯视觉方案通常依赖光流(optical flow)技术或目标跟踪推断速度,但这种方法精度不高,尤其在图像模糊、采样间隔变动等情况下更易失准,导致系统无法精准预测前方车辆运动趋势。

相反,毫米波雷达可以直接提供目标的径向速度数据,极大提升系统对周围动态变化的响应能力。在高速场景下,这种能力往往决定着自动驾驶系统的安全性。纯视觉方案在这一关键技术能力上的缺失,使其很难单独胜任高速自动驾驶任务。

安全冗余不足,难以满足L4以上自动驾驶要求

在自动驾驶等级逐步迈向L3/L4的过程中,对系统稳定性、故障容忍度、安全冗余的要求极高。任何一个传感器的短时失效,都可能导致严重后果。因此,各车企普遍采用“传感器冗余”策略,即多个不同类型的传感器相互印证,确保感知结果的可靠性。

纯视觉方案由于成本考虑,通常不设置冗余摄像头或多类型感知系统。一旦主摄像头遭遇污染、损坏、遮挡或软件崩溃,整个系统感知能力将大打折扣,甚至完全“失明”。这种单一感知模式的安全风险,无法满足高级别自动驾驶的可靠性要求。

尤其是在如Robotaxi、自动配送车等无人化运营场景中,无法依赖人工及时干预。一旦出现感知故障,车辆就只能停滞,甚至误操作,带来极大安全隐患。而多传感器融合方案由于具备更强容错能力,可通过其它传感器“顶上”,避免系统全盘瘫痪。

视觉是基础,融合才是未来

不可否认,视觉在自动驾驶感知中扮演着核心角色。摄像头具有成本低、体积小、信息密度高的优点,是自动驾驶的“眼睛”。但仅靠“眼睛”无法完成所有驾驶任务,尤其是在安全和冗余要求极高的L4/L5级别自动驾驶系统中,必须有“耳朵”(雷达)、“手指”(触觉)、“大脑”(地图与高精定位)等配合。

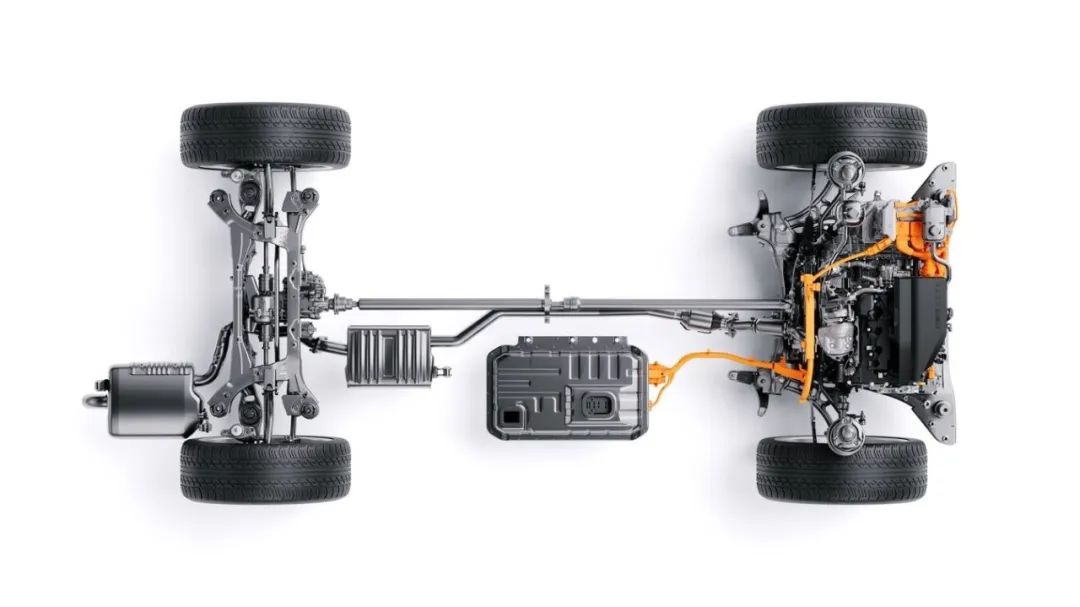

从技术演进趋势来看,真正具备规模部署能力的自动驾驶系统,大多采取“多传感器融合”路线。视觉、雷达、激光、超声波、IMU等共同构成复杂的传感系统,在不同场景下各司其职,相互补偿,以实现更安全、更可靠的感知能力。

纯视觉方案尽管在成本上具有优势,但从技术角度来看,其弊端决定了它无法独立支撑高级别自动驾驶的发展。未来自动驾驶的核心,不是“去雷达”,而是“用得合理”。盲目排斥非视觉传感器,不仅不能降低成本,反而可能增加系统出错的概率,反而得不偿失。

审核编辑 黄宇